Înțelegerea Adaptării cu Rang Mic - Low-Rank Adaptation (LoRA): Revoluționarea Fine-tuning-ului pentru Modele Mari de Limbaj (LLMs)

Acest document explorează abordarea inovatoare a Adaptării cu Rang Mic (LoRA), o tehnică concepută pentru a îmbunătăți eficiența și eficacitatea modelelor mari de limbaj (LLM). Pe măsură ce tehnologia AI continuă să avanseze, necesitatea unor soluții adaptabile și eficiente din punct de vedere al resurselor a devenit primordială, în special în contextul ajustării modelor masive precum GPT-3 și altele. LoRA abordează provocările asociate cu metodele tradiționale de ajustare, care cer adesea resurse computaționale extinse și timp.

LoRA introduce un cadru nou care valorifică matricele cu rang mic, permițând fine-tuning-ul eficient a modelelor mari fără necesitatea unei recalibrări complete. Concentrarea pe un subset mai mic de parametri reduce semnificativ sarcina computațională, făcând fezabilă ajustarea modelor pentru sarcini sau domenii specifice. Acest lucru nu numai că accelerează procesul de antrenare, ci îmbunătățește și performanța generală a modelelor în aplicații reale.

Pe parcursul acestui document, vom analiza complexitățile LoRA, examinând modul în care funcționează și avantajele pe care le aduce peisajului învățării automate. Prin furnizarea unei prezentări cuprinzătoare a metodologiilor LoRA și aplicațiilor practice, acest document își propune să echipeze cercetătorii, dezvoltatorii și entuziaștii AI cu cunoștințele necesare pentru a implementa această tehnică transformatoare în proiectele lor. Pe măsură ce navigăm în viitorul AI, înțelegerea LoRA va fi esențială pentru valorificarea întregului potențial al modelelor mari de limbaj.

Introducere

Domeniul inteligenței artificiale (AI) a realizat progrese remarcabile în ultimii ani, modelele mari de limbaj (LLM) precum GPT-4, LLaMa și Claude 2 demonstrând capacități fără precedent în înțelegerea limbajului natural, generarea de text și diverse alte aplicații. Totuși, aceste modele vin cu propriul set de provocări, în principal din cauza dimensiunii și complexității lor imense. Ajustarea acestor modele pentru a se adapta la sarcini sau domenii specifice necesită resurse computaționale semnificative și timp, făcând-o impracticabilă pentru multe cazuri de utilizare.

Aici intervine Adaptarea cu Rang Mic (LoRA). LoRA oferă o soluție inovatoare pentru problema ajustării modelelor mari prin reducerea sarcinii computaționale și eficientizarea procesului de fine-tuning. Acest articol va oferi un ghid cuprinzător pentru înțelegerea a ceea ce este LoRA, cum funcționează și de ce revoluționează domeniul învățării automate.

Obiective de Învățare

La finalul acestui articol, vei putea să:

- Definești “Adaptarea cu Rang Mic” (LoRA)

- Explici în termeni simpli cum funcționează LoRA

- Înțelegi avantajele utilizării LoRA în modelele de învățare automată

- Aplici LoRA în scenarii practice folosind biblioteci Python

Ce este Adaptarea cu Rang Mic (LoRA)?

Adaptarea cu Rang Mic (LoRA) este o tehnică concepută pentru a adapta eficient modelele mari de învățare automată la sarcini sau domenii noi fără a necesita recalibrare completă. Spre deosebire de metodele tradiționale de ajustare care necesită actualizarea tuturor parametrilor unui model, LoRA introduce componente ușoare, modificabile cunoscute sub numele de matrice cu rang mic în model. Aceste matrice sunt semnificativ mai mici și necesită mai puține resurse computaționale, făcând procesul de adaptare mai rapid și mai rentabil.

De ce avem nevoie de LoRA?

Pe măsură ce modelele de învățare automată au crescut în dimensiune, unele modele, precum GPT-3, conținând până la 175 de miliarde de parametri, procesul de ajustare a devenit din ce în ce mai intensiv din punct de vedere al resurselor. Ajustarea completă, care implică recalibrarea tuturor parametrilor unui model, poate fi prohibitv de costisitoare și consumatoare de timp. Acest lucru este deosebit de adevărat pentru aplicații specializate, cum ar fi adaptarea unui model pentru a funcționa în domenii specifice, cum ar fi sănătatea sau finanțele.

LoRA abordează aceste provocări prin permiterea ajustării eficiente a modelor mari. Concentrarea pe un subset mai mic de parametri reduce semnificativ resursele computaționale necesare, făcând fezabilă adaptarea modelor mari pentru sarcini specifice fără necesitatea recalibrării extinse.

Cum funcționează LoRA?

Conceptul de Matrci cu Rang Mic

Pentru a înțelege cum funcționează LoRA, este esențial să înțelegem mai întâi conceptul de matrice cu rang mic. În algebra liniară, o matrice este un aranjament rectangular de numere dispuse în rânduri și coloane. Rangul unei matrice se referă la numărul de rânduri sau coloane independent liniar pe care le conține, ceea ce reprezintă o măsură a „conținutului informațional” sau dimensiunii datelor reprezentate de matrice.

O matrice este considerată de rang mic dacă rangul său este mai mic decât rangul maxim posibil dat de dimensiunea sa. De exemplu, într-o matrice 3x3, dacă rangul este mai mic de 3, este considerată o matrice de rang mic. Matricele de rang mic sunt deosebit de utile în compresia datelor, unde ajută la reducerea cantității de date, păstrând cât mai multe informații posibil.

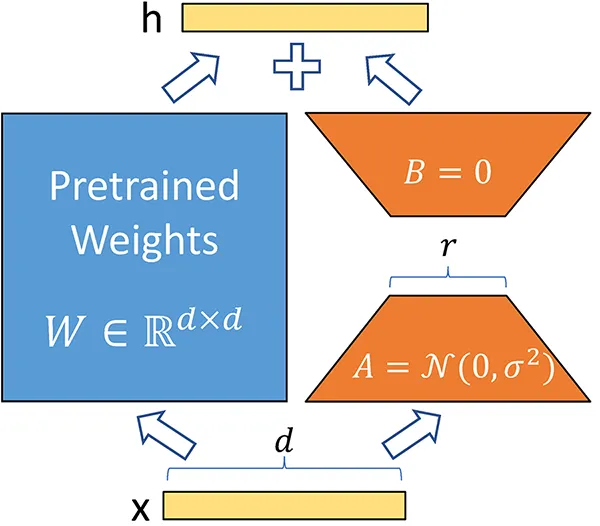

Aplicarea Matrcii de Rang Mic în LoRA

LoRA folosește conceptul de matrice cu rang mic pentru a face procesul de antrenare a modelului mai eficient. În loc să ajusteze toți parametrii unui model mare în timpul ajustării, LoRA descompune matricele mari de ponderi în matrice mai mici, de rang mic. Aceste matrice mai mici conțin mai puțini parametri, ceea ce reduce drastic numărul de parametri antrenabili.

De exemplu, într-un model precum GPT-3, care are 175 de miliarde de parametri, aplicarea LoRA poate reduce numărul de parametri antrenabili cu până la 10.000 de ori, aducându-l la aproximativ 17,5 milioane de parametri. Această reducere a numărului de parametri antrenabili nu doar că accelerează procesul de antrenare, dar și scade resursele computaționale necesare, făcându-l viabil din punct de vedere financiar să se ajusteze modele mari.

Înțelegerea LoRA cu Ajutorul Matrcii

Matrce de Ponderi Originală

Să considerăm o matrice mare de ponderi

Unde

Descompunerea Matrcii de Ponderi

În LoRA, descompunem matricea originală de ponderi

Unde:

Matricele pot fi reprezentate astfel:

Matricea A (Componenta de Rang Mic):

Matricea B (Componenta de Rang Mic):

Reprezentare Combinată

Reprezentarea combinată a matricei de ponderi originale folosind LoRA devine:

Antrenarea folosind LoRA

În timpul procesului de fine-tuning, doar parametrii matricelor de rang inferior ( A ) și ( B ) sunt actualizați, în timp ce matricea de ponderi originală ( W ) rămâne înghețată. Această abordare izolează efectiv antrenamentul pe un subset mai mic de parametri, reducând semnificativ sarcina computațională. Concentrându-ne pe matricile de rang inferior, minimizăm numărul de parametri antrenați, ceea ce duce la un proces de antrenament mai eficient în termeni de timp și utilizare a resurselor.

Raționamentul din spatele acestei tehnici este că majoritatea caracteristicilor învățate de model pot fi capturate eficient de aceste adaptații de rang inferior. Ca urmare, putem obține o performanță comparabilă cu metodele tradiționale de fine-tuning, dar cu semnificativ mai puțini parametri de optimizat. Acest lucru este deosebit de avantajos în scenarii în care resursele computaționale sunt limitate sau unde este necesară o iterație rapidă.

Pasul de actualizare (update) poate fi rezumat astfel:

În această ecuație,

Prin utilizarea acestei tehnici, ne asigurăm că structura de bază a modelului rămâne intactă, permițându-i totodată să se adapteze la informații noi. Această abordare nu numai că îmbunătățește eficiența procesului de antrenament, dar promovează și o implementare a modelului mai scalabilă, mai ales în aplicații unde actualizările trebuie să fie efectuate frecvent sau în timp real.

În plus, această metodă poate duce la o generalizare îmbunătățită. Deoarece parametrii originali rămân neschimbați, modelul își poate menține capacitățile învățate, câștigând totodată abilități suplimentare prin adaptațiile de rang inferior. Această balanță între stabilitate și adaptabilitate este crucială în construirea sistemelor AI robuste care pot gestiona sarcini diverse.

În concluzie, utilizarea LoRA în antrenament permite o abordare mai eficientă din punct de vedere al resurselor și scalabilă pentru fine-tuningul modelului, făcând-o o alegere atractivă pentru practicienii care doresc să îmbunătățească sistemele lor AI fără povara asociată cu metodele tradiționale.

Avantajele utilizării LoRA

- Costuri computaționale reduse: Antrenarea doar a matricelor de rang inferior scade numărul total de parametri de antrenat.

- Performanță menținută: În ciuda unui număr mai mic de parametri, performanța modelului poate rămâne ridicată datorită eficacității aproximărilor de rang inferior.

- Eficiență în stocare: Dimensiunea punctelor de verificare poate fi semnificativ redusă, deoarece matricile de rang inferior necesită mai puțin spațiu de stocare.

Rezumat

În concluzie, Adaptarea de Rang Inferior (LoRA) folosește decompoziția matricelor de ponderi în componente mai mici și mai gestionabile, permițând fine-tuningul eficient al modelor mari fără a suporta costul complet al reantrenării. Prin înțelegerea reprezentărilor și operațiunilor matriceale implicate, practicienii pot implementa eficient LoRA în proiectele lor de învățare automată.

Procesul LoRA în Detaliu

Procesul LoRA poate fi împărțit în următorii pași:

- Înghețarea Modelului Original: Modelul original pre-antrenat rămâne neschimbat, ceea ce înseamnă că niciunul dintre parametrii săi nu este alterat în timpul procesului de adaptare.

- Introducerea Matricelor de Rang Inferior: Matricile de rang inferior sunt introduse ca componente suplimentare în model. Aceste matrici sunt mici și conțin mai puțini parametri, ceea ce le face mai ușor de antrenat.

- Antrenarea Matricelor de Rang Inferior: În timpul fine-tuning-ului, doar parametrii matricelor de rang inferior sunt actualizați. Acest lucru reduce semnificativ povara computațională și accelerează procesul de antrenare.

- Inferență: La momentul inferenței, greutățile din matricile de rang inferior sunt adăugate la greutățile modelului original, permițând modelului să producă rezultate adaptate la sarcina sau domeniul specific.

Exemplu: Fine-Tuning GPT-3 cu LoRA

Pentru a ilustra cum funcționează LoRA în practică, să considerăm sarcina de fine-tuning a GPT-3 pentru un domeniu specific, cum ar fi sănătatea. Într-o abordare tradițională de fine-tuning, toate cele 175 de miliarde de parametri ai GPT-3 ar trebui să fie reantrenați, ceea ce ar necesita resurse computaționale substanțiale și timp.

Folosind LoRA, putem introduce în schimb matrici de rang inferior în model. Aceste matrici ar putea conține doar câteva milioane de parametri, care sunt apoi antrenați pe un set de date mai mic, specific domeniului sănătății. Modelul original GPT-3 rămâne neschimbat, iar doar matricile de rang inferior sunt actualizate. Odată ce antrenarea este completă, matricile de rang inferior sunt combinate cu parametrii modelului original, permițând GPT-3 să genereze texte adaptate la domeniul sănătății.

Avantajele LoRA

LoRA oferă mai multe avantaje cheie care o fac o opțiune atractivă pentru fine-tuning-ul modelelor de limbaj mari și altor modele de învățare automată.

-

Eficiență în Antrenare și Implementare

LoRA reduce semnificativ numărul de parametri care trebuie antrenați, ceea ce, la rândul său, reduce resursele computaționale necesare pentru antrenare. Acest lucru face posibil fine-tuning-ul modelelor mari pe hardware mai puțin puternic, făcând procesul mai accesibil și mai rentabil. -

Menținerea Calității și Vitezei Modelului

În ciuda reducerii numărului de parametri antrenați, LoRA menține calitatea și performanța modelului original. Utilizarea matricilor de rang inferior asigură că modelul adaptat poate genera în continuare rezultate de înaltă calitate fără a compromite viteza. -

Reducerea Dimensiunii Checkpoint-urilor

Unul dintre beneficiile practice ale LoRA este reducerea dimensiunii checkpoint-urilor. De exemplu, în cazul GPT-3, dimensiunea checkpoint-ului a fost redusă de la 1 TB la doar 25 MB atunci când s-a folosit LoRA. Această reducere a cerințelor de stocare facilitează gestionarea și implementarea modelelor în medii de producție. -

Fără Latente Adiționale la Inferență

LoRA nu introduce nicio latență suplimentară în timpul inferenței. Matricile de rang inferior sunt combinate cu parametrii modelului original pentru inferență, asigurându-se că viteza modelului rămâne neschimbată. Acest lucru permite comutarea rapidă a modelului în timpul execuției fără overhead suplimentar. -

Versatilitate

LoRA este o tehnică versatilă care poate fi aplicată oricărui model care utilizează înmulțirea matricilor. Aceasta include nu doar modele de limbaj mari, ci și alte tipuri de modele de învățare automată, cum ar fi mașinile cu vectori de suport. Aplicabilitatea extinsă a LoRA o face un instrument valoros pentru o gamă largă de aplicații.

LoRA în Modelele de Imagine: Stable Diffusion

Deși LoRA este discutată în principal în contextul modelelor de limbaj, este, de asemenea, adoptată pe scară largă în modelele de imagine precum Stable Diffusion. Principiile din spatele LoRA rămân aceleași, dar aplicația diferă ușor.

Adaptarea Modelelor de Imagine cu LoRA

În modelele de imagine precum Stable Diffusion, scopul principal al fine-tuning-ului este adesea specializarea stilului sau a caracterului. De exemplu, un model ar putea fi ajustat pentru a genera imagini într-un stil artistic specific, cum ar fi anime sau pictură în ulei, sau pentru a genera constant imagini ale unui anumit caracter.

Folosind LoRA, doar matricile de rang inferior sunt antrenate pe seturi de date mici care reflectă stilul sau caracterul dorit. Aceste matrici sunt apoi adăugate la modelul original, permițându-i să genereze imagini care corespund cerințelor specifice.

Cazuri de Utilizare în Stable Diffusion

Câteva utilizări comune ale LoRA în modelele Stable Diffusion includ:

- Specializarea Stilului: Adaptarea modelului pentru a genera imagini în stiluri specifice, cum ar fi anime sau pictură în ulei.

- Specializarea Caracterului: Ajustarea modelului pentru a genera constant imagini ale unor caractere specifice, cum ar fi Mario sau SpongeBob.

- Îmbunătățiri ale Calității: Îmbunătățirea calității imaginilor generate, cum ar fi detaliile faciale sau adăugarea unor texturi mai intricate.

Utilizatorii pot combina mai multe LoRA pentru a obține rezultate care reflectă simultan multiple specializări.

Combinarea LoRA cu Prefix-Tuning

O altă tehnică puternică care poate fi combinată cu LoRA este prefix-tuning. Prefix-tuning implică adăugarea unui prefix la secvența de intrare pe care modelul o procesează, ghidând efectiv ieșirea modelului către un stil sau domeniu specific.

Cum Funcționează Prefix-Tuning

În prefix-tuning, un număr mic de tokeni sunt adăugați la începutul secvenței de intrare. Acești tokeni sunt învățați în timpul procesului de fine-tuning și acționează ca un ghid pentru model, influențând ieșirea acestuia. Când este combinat cu LoRA, prefix-tuning permite un control și mai precis asupra comportamentului modelului.

Exemplu: Combinarea LoRA și Prefix-Tuning

Să considerăm un scenariu în care doriți să ajustați GPT-3 pentru a genera documente legale. Folosind LoRA, puteți reduce numărul de parametri antrenabili și concentra procesul de antrenament pe un set de date mai mic, specific domeniului legal. Apoi, prin aplicarea prefix-tuning, puteți adăuga câțiva tokeni la începutul fiecărei secvențe de intrare care ghidează modelul către generarea de text într-un stil formal, legalistic.

Această combinație de tehnici permite un fine-tuning extrem de eficient și eficace, permițând modelului să genereze rezultate care sunt strâns aliniate cu domeniul sau stilul dorit.

Aplicații Practice și Exemple

LoRA este o tehnică versatilă care poate fi aplicată într-o gamă largă de sarcini și domenii. Unele aplicații practice includ:

- Modele de Limbaj Personalizate: Ajustarea modelor mari de limbaj, cum ar fi GPT-3 sau GPT-4, pentru sarcini specifice, cum ar fi serviciul pentru clienți, generarea de documente legale sau scrierea creativă.

- Generarea de Imagini: Adaptarea modelor precum Stable Diffusion pentru a genera imagini în stiluri specifice sau cu personaje specifice.

- Recunoașterea Vocii: Ajustarea modelor de recunoaștere a vocii pentru a funcționa în medii zgomotoase sau pentru a recunoaște accente sau dialecte specifice.

- Sistemul de Sănătate: Adaptarea modelor pentru a funcționa în domeniul sănătății, unde confidențialitatea și securitatea sunt esențiale, iar resursele computaționale pot fi limitate.

Implementarea LoRA în Python

Implementarea practică a LoRA în Python este relativ simplă, datorită bibliotecilor precum Hugging Face Transformers, care oferă suport încorporat pentru LoRA.

Exemplu: Ajustarea GPT-3 cu LoRA

Iată un exemplu simplu despre cum să ajustați GPT-3 folosind LoRA în Python:

from transformers import GPT2Tokenizer, GPT2LMHeadModel, Trainer, TrainingArguments

# Load the pre-trained GPT-3 model and tokenizermodel = GPT2LMHeadModel.from_pretrained("gpt-3")tokenizer = GPT2Tokenizer.from_pretrained("gpt-3")

# Define the training datasettrain_dataset = [ {"input_ids": tokenizer.encode("Example input text", return_tensors="pt"), "labels": tokenizer.encode("Example output text", return_tensors="pt")}]

# Set up LoRA by defining low-rank matriceslora_rank = 8 # Set the rank of the low-rank matriceslora_matrices = model.add_low_rank_matrices(rank=lora_rank)

# Define the training argumentstraining_args = TrainingArguments( output_dir="./results", num_train_epochs=3, per_device_train_batch_size=2, save_steps=10_000, save_total_limit=2, logging_dir="./logs",)

# Create the Trainer objecttrainer = Trainer( model=model, args=training_args, train_dataset=train_dataset,)

# Train the modeltrainer.train()

# Save the fine-tuned modelmodel.save_pretrained("./fine-tuned-gpt-3")Acest exemplu demonstrează cum să configurați LoRA pentru fine-tuning GPT-3, să reduceți numărul de parametri de antrenament prin introducerea de matrice de rang inferior și apoi să antrenați modelul pe un set mic de date.

Concluzie

Adaptarea de Rang Inferior (LoRA) este o tehnică revoluționară care abordează provocările fine-tuning-ului modelelor mari. Prin reducerea numărului de parametri de antrenament și valorificarea puterii matricelor de rang inferior, LoRA face procesul de adaptare mai eficient, rentabil și accesibil. Indiferent dacă lucrați cu modele mari de limbaj precum GPT-3 sau cu modele de imagine precum Stable Diffusion, LoRA oferă o soluție puternică pentru fine-tuning-ul modelelor pentru a satisface nevoile specifice.

Pe măsură ce AI continuă să evolueze, tehnici precum LoRA vor juca un rol crucial în adaptarea și versatilitatea modelelor avansate de învățare automată. Prin stăpânirea LoRA, veți fi bine pregătit să profitați de cele mai recente progrese din domeniu și să le aplicați în propriile proiecte.

Rezumat

- LoRA: O tehnică pentru adaptarea eficientă a modelor mari prin introducerea de matrici de rang inferior, reducând numărul de parametri de antrenament.

- Avantaje: Antrenament eficient, dimensiuni reduse ale punctelor de control, fără latență suplimentară în timpul inferenței, aplicabilitate versatilă în diverse modele.

- Cazuri de Utilizare Practică: Modele de limbaj, generarea de imagini, recunoașterea vocii și altele.

- Implementare: LoRA poate fi implementată în Python folosind biblioteci precum Hugging Face Transformers, permițând fine-tuning-ul eficient al modelor precum GPT-3.

Urmând ghidul furnizat în acest articol, veți putea implementa LoRA în propriile proiecte și să profitați de numeroasele sale beneficii.

Bot Personalizat Gratuit ChatGPT cu BotGPT

Pentru a valorifica pe deplin potențialul LLM-urilor pentru nevoile dumneavoastră specifice, luați în considerare crearea unui chatbot personalizat adaptat la datele și cerințele dumneavoastră. Explorați BotGPT pentru a descoperi cum puteți profita de tehnologia avansată AI pentru a construi soluții personalizate și a vă îmbunătăți proiectele de afaceri sau personale. Prin îmbrățișarea capabilităților BotGPT, puteți rămâne cu un pas înainte în peisajul în evoluție al AI-ului și debloca noi oportunități de inovație și interacțiune.

Descoperiți puterea asistentului nostru virtual versatil, alimentat de tehnologia de vârf GPT, adaptat pentru a satisface nevoile dumneavoastră specifice.

Funcții

-

Îmbunătățiți Productivitatea: Transformați fluxul de lucru cu eficiența BotGPT. Începeți

-

Integrare Seamless: Integrați cu ușurință BotGPT în aplicațiile dumneavoastră. Aflați Mai Multe

-

Optimizați Crearea de Conținut: Creșteți procesul de creare și editare a conținutului cu BotGPT. Încercați Acum

-

Asistență Virtuală 24/7: Accesați BotGPT oricând, oriunde pentru suport instantaneu. Explorați Aici

-

Soluții Personalizabile: Adaptați BotGPT pentru a se potrivi perfect cerințelor afacerii dumneavoastră. Personalizați Acum

-

Informații Bazate pe AI: Descoperiți informații valoroase cu capabilitățile avansate ale BotGPT. Descoperiți Mai Multe

-

Deblocați Funcții Premium: Faceți upgrade la BotGPT pentru funcții exclusive. Faceți Upgrade Astăzi

Despre BotGPT

BotGPT este un chatbot puternic alimentat de tehnologia avansată GPT, conceput pentru integrare seamless pe diverse platforme. Îmbunătățiți productivitatea și creativitatea cu asistența virtuală inteligentă oferită de BotGPT.

Conectați-vă cu noi la BotGPT și descoperiți viitorul asistenței virtuale.