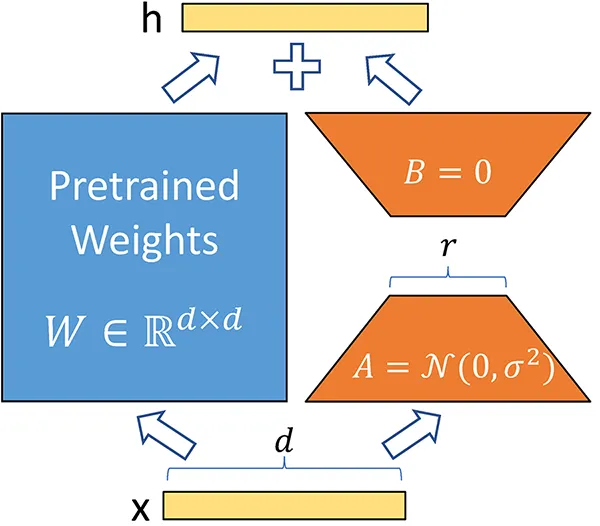

Înțelegerea Adaptării cu Rang Mic - Low-Rank Adaptation (LoRA): Revoluționarea Fine-tuning-ului pentru Modele Mari de Limbaj (LLMs)

Acest articol explorează Adaptarea cu Rang Mic (LoRA), o tehnică transformatoare pentru ajustarea eficientă a modelelor mari de limbaj (LLM) precum GPT-4 și Stable Diffusion. Prin reducerea sarcinii computaționale a adaptării acestor modele, LoRA permite procese de antrenare mai rapide și mai rentabile. Vom acoperi principiile sale, avantajele și aplicațiile practice, precum și vom oferi un ghid de implementare practică folosind biblioteci Python.